Los algoritmos y arquitecturas, que ayudan a identificar y predecir patrones y comportamientos de los dispositivos inteligentes, requieren de enormes cantidades de memoria, computación y datos para entrenar y hacer inferencias. Para mejorar la eficacia de los algoritmos, un equipo de investigadores del Instituto Tecnológico de Massachussets (MIT), que trabaja en el campo de tinyML en el MIT-IBM Watson AI Lab, ha desarrollado una técnica para reducir la cantidad de memoria necesaria, al tiempo que mejora el rendimiento en el reconocimiento de imágenes en vídeos en vivo.

Los investigadores también están trabajando para reducir el tamaño y la complejidad de los dispositivos en los que se pueden ejecutar estos algoritmos hasta una unidad de microcontrolador (MCU) que se encuentra en los dispositivos de IoT. Una MCU es una minicomputadora con memoria limitada alojada en un circuito integrado compacto que carece de un sistema operativo y ejecuta comandos simples.

Para aumentar la eficiencia de tinyML, los investigadores analizaron cómo se usa la memoria en microcontroladores que ejecutan varias redes neuronales convolucionales (CNN). Las CNN son modelos inspirados biológicamente después de las neuronas en el cerebro y se aplican para evaluar e identificar características visuales dentro de las imágenes, como una persona que camina a través de un cuadro de vídeo.

En su estudio descubrieron un desequilibrio en la utilización de la memoria, lo que provocaba una carga frontal en el chip de la computadora y creaba un cuello de botella. Al desarrollar una nueva técnica de inferencia y arquitectura neuronal, el equipo alivió el problema y redujo el uso máximo de memoria de cuatro a ocho veces.

Dispositivo MCUNetV2

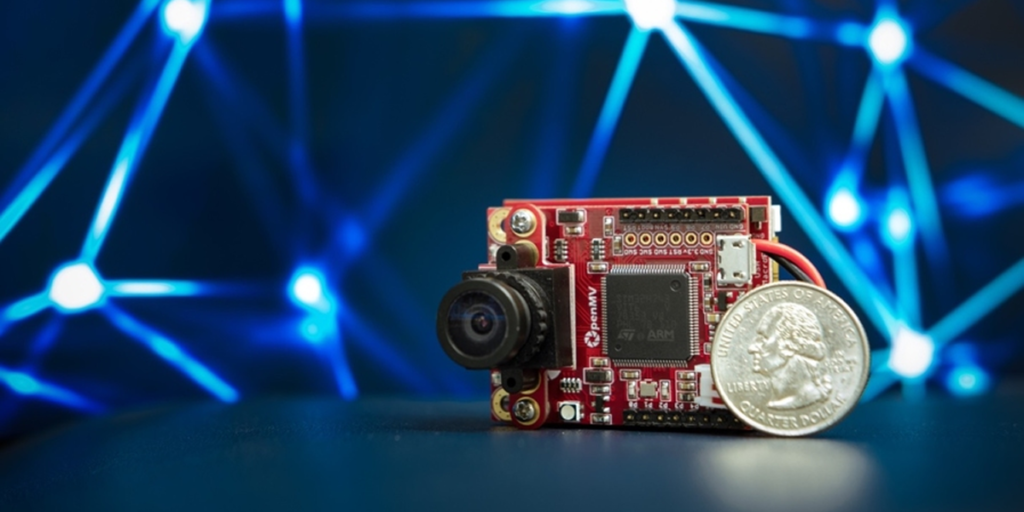

Por otro lado, los investigadores desarrollaron MCUNetV2, un sistema equipado con una cámara, capaz de detectar humanos y objetos, que se implementó en su propio sistema de visión tinyML. El codiseño de la arquitectura de la red con la optimización de la búsqueda de la red neuronal y la programación de inferencias proporcionó ganancias significativas y fue adoptado en MCUNetV2, que superó a otros sistemas de visión en el uso máximo de memoria y en la detección y clasificación de imágenes y objetos.

El dispositivo MCUNetV2 incluye una pantalla pequeña y una cámara de vídeo, y tiene aproximadamente el tamaño de un estuche para auriculares. En comparación con la primera versión, la nueva versión necesitaba cuatro veces menos memoria para la misma cantidad de precisión.

Cuando se comparó cara a cara con otras soluciones tinyML, MCUNetV2 pudo detectar la presencia de objetos en marcos de imágenes, como rostros humanos, con una mejora de casi el 17%. Además, estableció un récord de precisión, de casi el 72%, para una clasificación de imágenes de mil clases en el conjunto de datos de ImageNet, utilizando 465 KB de memoria.

Los investigadores probaron lo que se conoce como palabras de vigilia visual, su modelo de visión de MCU podría identificar la presencia de una persona dentro de una imagen, e incluso con la memoria limitada de solo 30 KB, logró una precisión superior al 90%, superando el estado anterior. Esto significa que el método es lo suficientemente preciso y podría implementarse para ayudar, por ejemplo, en aplicaciones de viviendas inteligentes.