Muchos sistemas informáticos con los que las personas interactúan a diario requieren conocimientos sobre ciertos aspectos del mundo real o modelos para funcionar. Estos sistemas deben ser entrenados para aprender a reconocer objetos a partir de datos de vídeo o imagen. Los investigadores de la Universidad de Tokio (Japón) han encontrado una manera de incorporar los gestos naturales con las manos en el proceso de enseñanza.

Con este nuevo modelo, los usuarios pueden enseñar a las máquinas los objetos más fácilmente y las máquinas también pueden aprender de manera más efectiva, mejorando así la enseñanza automática, al tiempo que se obtiene un sistema de aprendizaje automático más preciso.

Los investigadores han abordado dos problemas fundamentales en la enseñanza automática: la eficiencia de la enseñanza, con el objetivo de minimizar el tiempo de los usuarios y el conocimiento técnico requerido; y la eficiencia del aprendizaje, garantizar mejores datos de aprendizaje para que las máquinas desarrollen modelos.

Incorporación de los gestos de las manos en la enseñanza automática

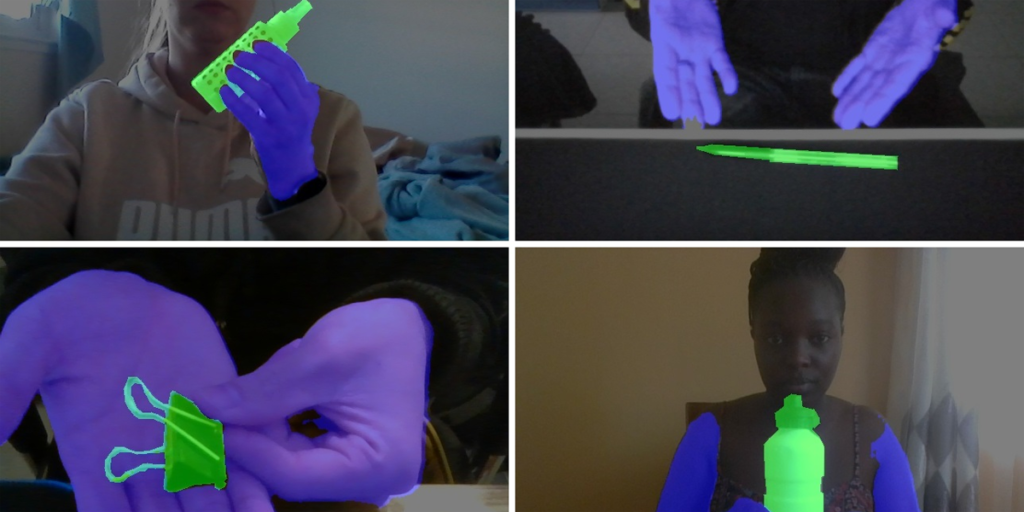

Para la eficiencia del aprendizaje, los investigadores incorporaron los gestos de las manos de los usuarios en la forma en que se procesa una imagen antes de que la máquina la incorpore a su modelo, conocido como HuTics. Por ejemplo, un usuario puede señalar o presentar un objeto a la cámara de una manera que enfatice su importancia en comparación con los otros elementos de la escena.

A pesar de que la idea era bastante sencilla, su implementación fue complicada, ya que las personas son diferentes y no hay un conjunto estándar de gestos con las manos. Para que el modelo fuera efectivo, se recopilaron 2.040 vídeos de ejemplo de 170 personas presentando objetos a la cámara en HuTics.

Estos activos se anotaron para marcar qué era parte del objeto y qué partes de la imagen eran solo las manos de la persona. Otro sistema, denominado LookHere, encargado de enseñar a las máquinas sobre objetos físicos mediante datos visuales, se entrenó con HuTics. Como resultado, en comparación con otros enfoques de reconocimiento de objetos, LookHere es capaz de determinar mejor qué partes de una imagen entrante se deben usar para construir sus modelos.

Para garantizar la accesibilidad del sistema, los usuarios pueden usar sus teléfonos inteligentes para trabajar con LookHere, mientras que el procesamiento real se realiza en servidores remotos. Los investigadores descubrieron que LookHere puede crear modelos hasta 14 veces más rápidos que algunos sistemas existentes.