Un grupo de investigadores del Instituto Tecnológico de Massachussets (MIT), MIT-IBM Watson AI Lab e IBM Research, entre otros, ha desarrollado una nueva técnica para analizar datos de audio y vídeo sin etiquetar, que podría mejorar el rendimiento de los modelos de aprendizaje automático utilizados en aplicaciones como el reconocimiento de voz y la detección de objetos. Para ello, se han combinado dos arquitecturas de aprendizaje autosupervisado: aprendizaje contrastivo y modelado de datos enmascarados.

La técnica, llamada autocodificador contrastivo audiovisual enmascarado (CAV-MAE), es un tipo de red neuronal que puede aprender a extraer y mapear representaciones latentes significativas en un espacio de alta dimensión a partir de datos acústicos y visuales mediante el entrenamiento en grandes conjuntos de datos de YouTube de clips de audio y vídeo de 10 segundos. Los investigadores consideran que la técnica es más efectiva que los enfoques anteriores porque modela explícitamente las relaciones entre los datos de audio y vídeo de una manera que no lo hacen otros métodos.

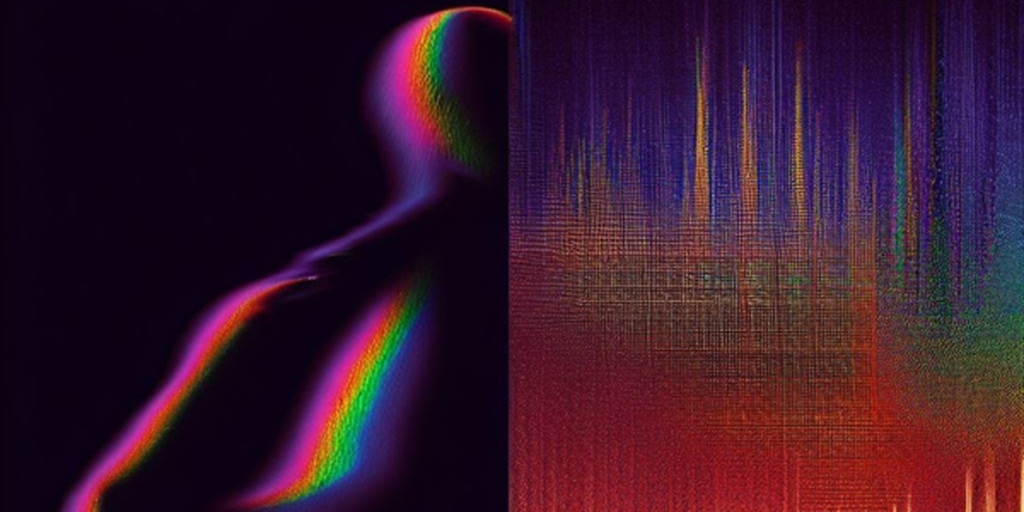

El CAV-MAE funciona aprendiendo por predicción y aprendiendo por comparación. El modelado de datos enmascarados, o el método de predicción, toma un vídeo junto con su forma de onda de audio coordinada, convierte el audio en un espectrograma y enmascara el 75% de ambos.

Los datos desenmascarados se tokenizan, se integran en codificadores de audio y vídeo separados antes de ingresar a un codificador/descodificador conjunto, donde se le pide al modelo que recupere los datos que faltan. La diferencia entre la predicción reconstruida resultante y la combinación audiovisual original se usa posteriormente para entrenar el modelo para un mejor rendimiento.

Recuperación audiovisual a través de CAV-MAE

Los investigadores probaron CAV-MAE con otros métodos de última generación en tareas de recuperación audiovisual y clasificación de eventos audiovisuales utilizando AudioSet estándar (20 K y 2 M) y conjuntos de datos VGGSound, clips cortos etiquetados y realistas, que podrían incluir múltiples sonidos. La recuperación audiovisual significa que el modelo ve el componente de audio o vídeo de un par de consultas y busca el que falta. La clasificación de eventos incluye la identificación de acciones o sonidos dentro de los datos, como una persona cantando o conduciendo un automóvil.

En general, encontraron que el aprendizaje contrastivo y el modelado de datos enmascarados son métodos complementarios. CAV-MAE fue capaz de superar las técnicas anteriores en aproximadamente un 2% para el rendimiento de la clasificación de eventos frente a modelos con computación comparable y siguió el ritmo o superó a los modelos con recursos computacionales de nivel industrial.

El modelo del equipo se clasificó de manera similar a los modelos entrenados solo con la pérdida contrastiva. Además, la incorporación de datos multimodales en el entrenamiento previo de CAV-MAE mejora en gran medida el ajuste fino de la representación de una sola modalidad a través del aprendizaje supervisado y el rendimiento en tareas de clasificación de eventos de solo audio.

Los investigadores ven su contribución del autocodificador contrastivo audiovisual enmascarado como un hito importante y un paso adelante para las aplicaciones, que se están moviendo cada vez más de la modalidad única a la multimodalidad y que requieren o aprovechan la fusión audiovisual. Tienen la hipótesis de que en el futuro podría usarse para el reconocimiento de acciones en ámbitos como los deportes, la educación, el entretenimiento, los vehículos motorizados y la seguridad pública, así como extenderse a otras modalidades.