Los sistemas de inteligencia artificial (IA) manejan datos confidenciales y realizan tareas a veces críticas en una amplia gama de entornos. El instituto de investigación CEA-Leti ha investigado las vulnerabilidades físicas inherentes a los dispositivos comunes IoT, en concreto en los modelos de redes neuronales profundas en microcontroladores de 32 bits, para desarrollar nuevos formas de evaluar la IA, con el fin de mejorar la seguridad.

Para los modelos de aprendizaje automático y, especialmente, las redes neuronales profundas (DNN), la superficie de ataque es particularmente compleja. Estos sistemas son abstracciones matemáticas implementadas físicamente en un entorno que incluye software y hardware.

Dado que los parámetros internos del modelo de redes neuronales profundas se almacenan localmente en la memoria del dispositivo, son objetivos para ataques que buscan manipular estos parámetros para realizar ingeniería inversa en los modelos o alterar su comportamiento.

Los investigadores de CEA-Leti han demostrado el impacto de los ataques bit-flip (BFA) en los modelos de inteligencia artificial. Solo un puñado de bit-flips podría degradar significativamente el rendimiento de los modelos de redes neuronales convolucionales, lo que genera serias preocupaciones de seguridad y evaluación.

Hasta ahora, la mayor parte de la investigación se ha centrado en la DRAM, demostrando la relevancia y efectividad del uso de conjuntos de bits (en lugar de cambios de bits) para un ataque tipo BFA, para extraer información confidencial de un modelo de caja negra protegido. Al analizar las decisiones de salida del modelo con y sin fallas para descubrir valores de parámetros, los atacantes pueden usarlos en ataques de ingeniería inversa.

Protocolos de evaluación y simulación

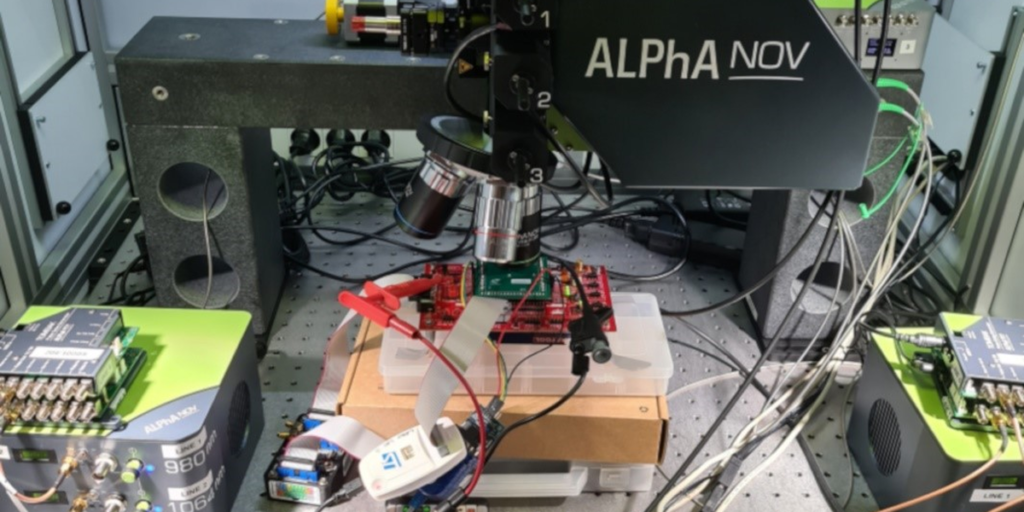

La investigación de CEA-Leti traza un rumbo hacia protocolos de evaluación sólidos para modelos de inteligencia artificial integrados en plataformas Cortex-M con memoria flash. Para ello, utilizaron un análisis teórico e inyección de fallas láser para comprender mejor las relaciones entre las características del modelo y la eficiencia del ataque.

Su trabajo también ha demostrado el valor de la simulación para facilitar la evaluación de modelos de IA. Estos avances en la evaluación de la seguridad de la IA serán cruciales para certificar y diseñar mecanismos de protección para los sistemas de IA integrados.