El uso de la tecnología de realidad virtual (RV) ha revolucionado la forma en que se experimenta los entornos digitales, pero tiene un inconveniente: oculta los datos visuales del mundo real. Para mitigar esta limitación y mejorar la experiencia general del usuario, resulta esencial incorporar otros canales sensoriales. En esta línea, el proyecto multiTOUCH ha proporcionado formación de alto nivel a una nueva generación de investigadores en etapa inicial (ESR) en el campo multidisciplinario de la háptica. Además, ha desarrollado un novedoso concepto de interacción, denominado Hap2Gest, basado en gestos de superficie y motores de vibración.

Desde los smartphones hasta los dispositivos inteligentes, las pantallas táctiles se han convertido en una parte omnipresente de la vida cotidiana. Si bien estas pantallas sin botones fueron diseñadas para hacer que la tecnología sea más fácil de usar y, por lo tanto, más accesible para más personas, al hacerlo pueden terminar excluyendo a las personas con discapacidad visual y auditiva.

Por ello, multiTOUCH ha introducido la retroalimentación táctil con la retroalimentación auditiva y visual en las interfaces hombre-computadora (HCI) multisensoriales de próxima generación. De esta forma, se combinan retroalimentación táctil, auditiva y visual, como pantallas táctiles multisensoriales (TD) y configuraciones de realidad virtual (VR) multisensoriales, con el objetivo de producir una experiencia de usuario enriquecida.

Formación de investigadores en la tecnología háptica

Para conseguir este objetivo, el proyecto multiTOUCH ha formado un equipo multidisciplinar de jóvenes investigadores que han abordado varios campos de investigación, como neurociencias cognitivas y de sistemas: comprender, mediante mediciones psicofísicas y neurofisiológicas, cómo el cerebro integra la información táctil con la información auditiva y visual durante el tacto activo y, de ese modo, definir los requisitos para producir una retroalimentación auditiva-táctil y visual-táctil perceptualmente coherente en HCI multisensoriales (TD multisensoriales y configuraciones de VR).

También se han centrado en la ingeniería y física para proporcionar dispositivos innovadores y robustos que permitan la retroalimentación multisensorial al usuario, incluyendo su control y el hardware de instrumentación necesario para su implementación en HCIs multisensoriales de próxima generación.

Por último, han investigado en el campo de las ciencias de la computación, que ha permitido desarrollar técnicas de interacción que aprovechen las HCI multisensoriales, para evaluarlas en aplicaciones para el público en general (aplicaciones de consumo), así como para el sector de la salud (aplicaciones médicas para rehabilitación).

Concepto de interacción Hap2Gest

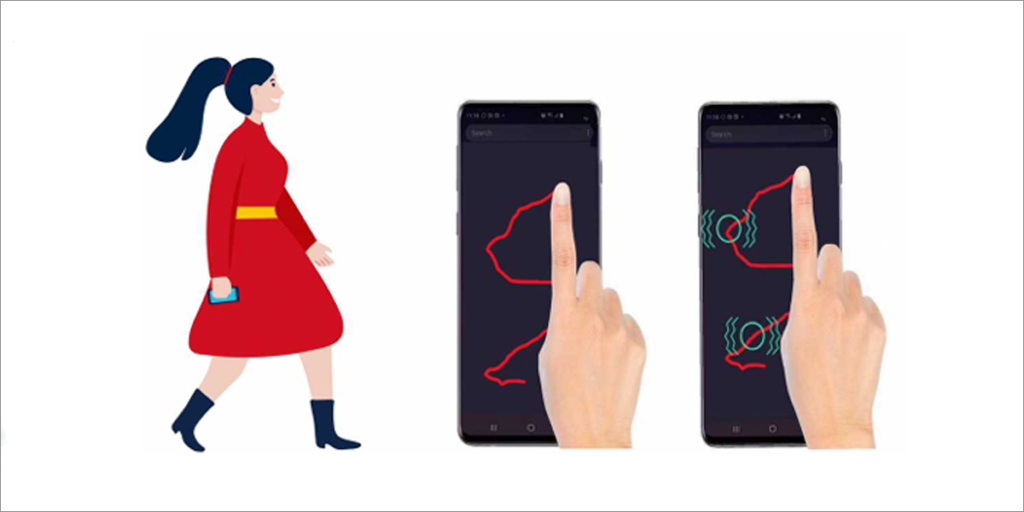

Todas estas investigaciones han dado como resultado Hap2Gest, un novedoso concepto de interacción basado en gestos de superficie y motores de vibración, que permite el accionamiento de comandos y la recuperación de información, ambas sin necesidad de utilizar los ojos.

A través de Hap2Gest, el usuario dibuja un gesto de entrada sin necesidad de utilizar los ojos para pedirle al sistema que active un comando. Posteriormente, dibuja un gesto de salida sin necesidad de utilizar los ojos a través del cual el usuario siente los patrones de vibración que constituyen la información de salida.

Para desarrollar Hap2Gest, los investigadores llevaron a cabo un estudio para comprender los gestos y los patrones de vibración preferidos por los usuarios para diferentes escenarios de interacción multiTOUCH (háptica multimodal con dispositivos táctiles). Dado que los movimientos precisos de los dedos son cruciales para que el teléfono inteligente proporcione retroalimentación háptica en el lugar correcto durante la producción de gestos, se examinaron factores como la velocidad al caminar, la ubicación del teléfono, la mano utilizada y el impacto de las tareas simultáneas en estos gestos sin utilizar los ojos.

La investigación reveló cómo cambian las formas de los gestos en diferentes condiciones, lo que permite respuestas de vibración más precisas. Por ejemplo, se puede usar el acelerómetro del smartphone para medir la velocidad al caminar de un usuario y ajustar el tamaño del gesto en consecuencia; cuanto más rápido camina el usuario, más grande es el gesto que dibuja sin cambiar la duración del gesto. Por otro lado, realizar la tarea principal mientras dibuja un gesto reduce tanto el tamaño como la duración del gesto, al tiempo que mantiene la misma velocidad de producción del gesto.

Asimismo, usar la mano no dominante para dibujar el gesto aumenta el tamaño del gesto. Además, se exploró la viabilidad de realizar gestos sin utilizar los ojos a través de la tela de un bolsillo de pantalones cuando el teléfono inteligente está guardado en el interior.

Los resultados del estudio no solo demostraron qué gestos prefieren los usuarios para la interacción sin ojos con las pantallas, sino que también mostraron cómo prefieren recibir retroalimentación háptica. Asimismo, se obtuvo información sobre los índices de acuerdo en términos de forma del gesto, perfil de velocidad del gesto y patrón de vibración, que ayudó a crear un conjunto de gestos más naturales y patrones de vibración adaptados al usuario.

De esta forma, se ha conseguido proporcionar una nueva forma de interactuar con los smartphones sin necesidad de utilizar la retroalimentación visual (Hap2Gest), apoyándose en los motores de vibración y las pantallas táctiles que se encuentran en la mayoría de los teléfonos inteligentes modernos. Este enfoque que no requiere usar la vista y que utiliza la retroalimentación háptica puede utilizarse, por ejemplo, para utilizar los smartphones mientras se participa en una experiencia de realidad virtual, para no interrumpirla.

Manual de buenas prácticas

Los investigadores del proyecto multiTOUCH también han presentado el ‘Manual de buenas prácticas para estímulos táctiles, visuales y auditivos mixtos‘, con el objetivo de que sirva como base para la creación de una nueva generación de dispositivos multisensoriales. Este documento está especialmente dirigido a investigadores y profesionales en háptica.

El manual está estructurado en varios capítulos de una página con los principales hallazgos, implicaciones y posibles aplicaciones. Los temas que se abordan en el documento son la entrada sensorial, el tacto activo, el refuerzo sensorial, la sustitución sensorial, la pantalla háptica, la resonancia magnética funcional (fMRI) y la intermodalidad.

Asimismo, el manual presenta un conjunto seleccionado de referencias clave a artículos científicos que se publicaron dentro del consorcio multiTOUCH.