Los recursos informáticos necesarios para entrenar las redes neuronales para la inteligencia artificial (IA) implican un enorme consumo de energía. Los investigadores de la Universidad Técnica de Múnich (TUM) han desarrollado un método de entrenamiento de redes neuronales 100 veces más rápido y, por lo tanto, mucho más eficiente energéticamente. En lugar de adoptar un enfoque iterativo, los parámetros se calculan directamente en función de las probabilidades, lo que permite reducir el consumo energético.

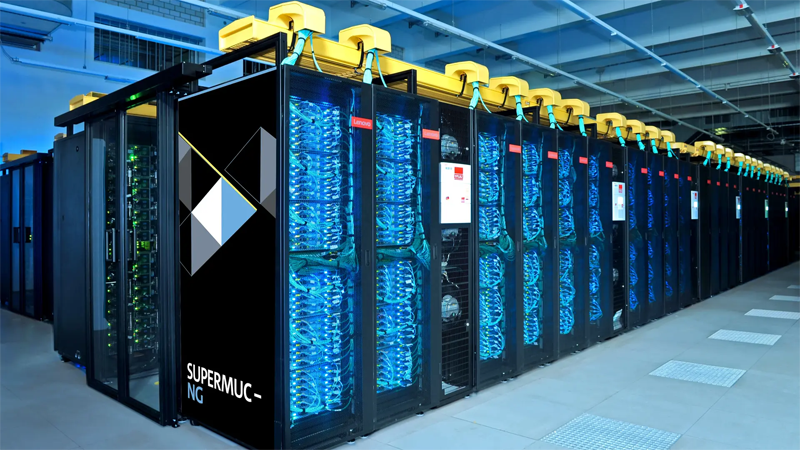

Las aplicaciones de IA, como los grandes modelos lingüísticos (LLM), se han convertido en parte integral de la vida cotidiana. Las capacidades de procesamiento, almacenamiento y transmisión necesarias las proporcionan centros de datos que consumen enormes cantidades de energía.

La aparición de aplicaciones de IA más complejas en los próximos años aumentará considerablemente la demanda de capacidad de los centros de datos, además de consumir grandes cantidades de energía para el entrenamiento de redes neuronales. Para contrarrestar esta tendencia, los investigadores han desarrollado un método de entrenamiento que es 100 veces más rápido y logra una precisión comparable a los procedimientos existentes. Esto reducirá significativamente el consumo de energía para el entrenamiento.

Enfoque de probabilidades para el entrenamiento de redes neuronales

El nuevo método utiliza un enfoque de probabilidades, en vez de determinar de manera repetida los parámetros entre los nodos. El método probabilístico se basa en el uso específico de valores en lugares críticos de los datos de entrenamiento donde se producen cambios grandes y rápidos en los valores.

El método permite determinar los parámetros necesarios con un mínimo de potencia de cálculo. Esto puede hacer que el entrenamiento de redes neuronales sea mucho más rápido y, en consecuencia, más eficiente energéticamente.

El objetivo del estudio actual es utilizar este enfoque para obtener sistemas dinámicos de ahorro de energía a partir de los datos. Estos sistemas cambian con el transcurso del tiempo de acuerdo con ciertas reglas y se encuentran, por ejemplo, en los modelos climáticos y en los mercados financieros.

Entrenamiento de las redes neuronales

El funcionamiento de las redes neuronales, que se utilizan en la IA para tareas como el reconocimiento de imágenes o el procesamiento del lenguaje, se inspira en el funcionamiento del cerebro humano. Estas redes están formadas por nodos interconectados llamados neuronas artificiales. Las señales de entrada se ponderan con determinados parámetros y luego se suman. Si se supera un umbral definido, la señal se transmite al siguiente nodo.

Para entrenar la red, la selección inicial de valores de parámetros suele ser aleatoria, por ejemplo, utilizando una distribución normal. A continuación, los valores se ajustan de forma incremental para mejorar gradualmente las predicciones de la red. Debido a las numerosas iteraciones necesarias, este entrenamiento es extremadamente exigente y consume mucha electricidad.